تاریخچه و تکامل یادگیری عمیق

فهرست مطالب

- 1 تاریخچه و تکامل یادگیری عمیق

- 2 انواع مدل های یادگیری عمیق

- 3 بهترین روشهای پیادهسازی یادگیری در پروژه ها

- 4 ترندهای یادگیری عمیق

- 5 ابزارهای کلیدی در حوزه یادگیری عمیق

- 6 مهارت های مورد نیاز برای پیاده سازی یادگیری عمیق

- 7 فرآیندهای بالادستی و پاییندستی در یادگیری عمیق

- 8 تأثیر یادگیری عمیق بر کسب و کار

- 9 چکلیست اجرایی یادگیری عمیق

- 10 نقش مشاوران در پیادهسازی یادگیری عمیق

- 10.1 3 سطح ارزشآفرینی

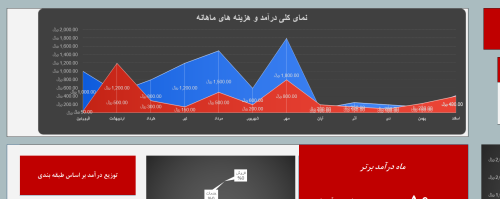

- 10.2 قالب اکسل داشبورد درآمد و هزینه

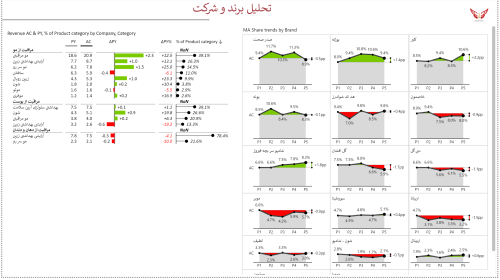

- 10.3 داشبورد کالاهای مصرفی تندگردش – Brand and Product Portfolio Analysis Power BI Template

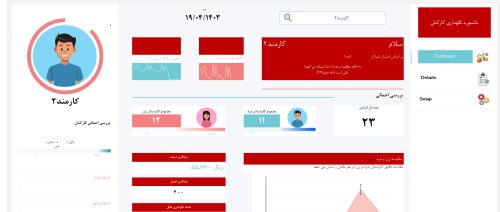

- 10.4 قالب اکسل داشبورد مدیریت کارکنان

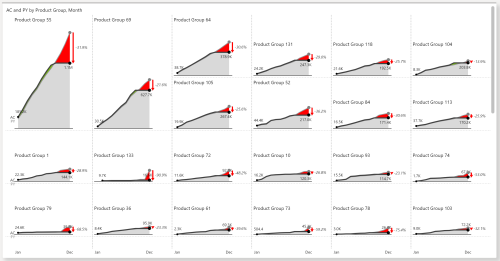

- 10.5 داشبورد فروش و بازاریابی – Sales Dashboard in Power BI

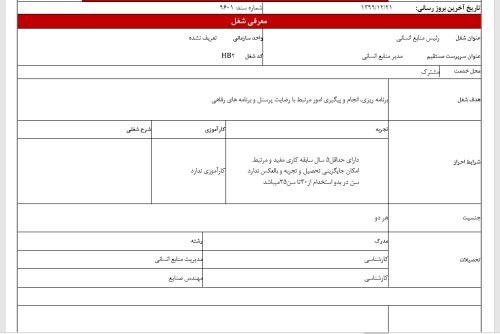

- 10.6 بسته کامل شرح شغلی برای سازمان ها و شرکت ها

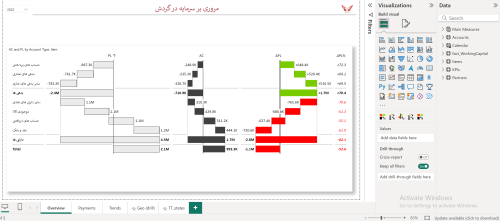

- 10.7 داشبورد مالی و بهای تمام شده – Working Capital in Power BI

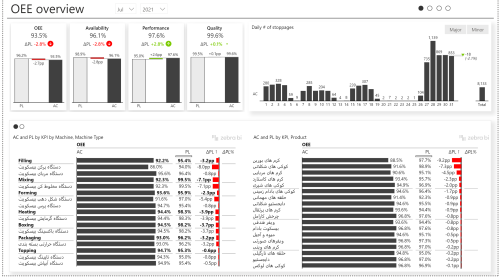

- 10.8 داشبورد تولید، برنامه ریزی تولید، نگهداری و تعمیرات

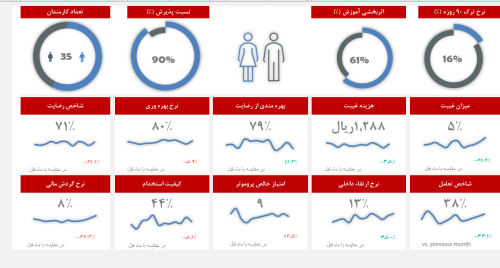

- 10.9 قالب اکسل داشبورد مدیریت منابع انسانی

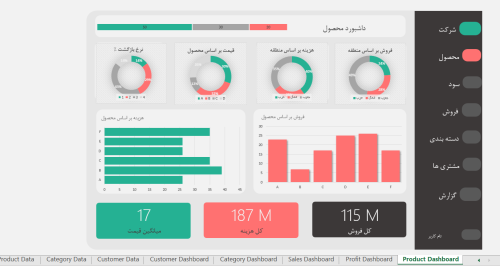

- 10.10 داشبورد مدیریت فروش، مشتری، محصول، مالی و حسابداری

- 10.11 قالب داشبورد شاخص های مدیریت عملکرد منابع انسانی

- 10.12 داشبورد شاخص های کلیدی عملکرد تولید و برنامه ریزی | KPI

- 10.13 بسته کامل فرم ها، شاخص ها و شرح شغل های کسب و کاری

- 10.14 داشبورد منابع انسانی – HR Analytics in Power BI

یادگیری عمیق، شاخهای از هوش مصنوعی و یادگیری ماشین است که با الهام از ساختار مغز انسان، به ساخت شبکههای عصبی مصنوعی با لایههای متعدد میپردازد. این شبکهها قادرند الگوهای پیچیده را از حجم وسیعی از دادهها استخراج کرده و در وظایفی نظیر تشخیص تصویر، پردازش زبان طبیعی و پیشبینی سریهای زمانی عملکردی چشمگیر از خود نشان دهند. درک ریشهها و نقاط عطف تکامل این حوزه، دیدگاه جامعی نسبت به توانمندیها و مسیر پیش روی آن ارائه میدهد.

ریشهشناسی

اصطلاح Deep Learning اولین بار در سال 1986 توسط رینا دچتر (Rina Dechter) در زمینه شبکههای عصبی و استدلال مطرح شد. با این حال، مفهوم “Deep” در این عبارت به طور خاص به شبکههای عصبی چندلایه اشاره دارد که امکان یادگیری سطوح انتزاعی مختلف از دادهها را فراهم میکنند. این ایده، ریشه در تلاشهای اولیه برای مدلسازی عملکرد مغز انسان با استفاده از شبکههای نورونی مصنوعی دارد.

نقاط عطف تاریخی

- 1943: مدل ریاضی نورون توسط مککالوخ و پیتز (McCulloch and Pitts): وارن مککالوخ (Warren McCulloch) و والتر پیتز (Walter Pitts) با ارائه یک مدل ریاضی ساده از نورون بیولوژیکی، پایههای محاسباتی شبکههای عصبی مصنوعی را بنا نهادند. این مدل، نحوه دریافت ورودیها، تجمیع آنها و تولید خروجی توسط یک نورون مصنوعی را شرح میداد.

- دهه 1950-1960: ظهور پرسپترون و آدالاین: فرانک روزنبلات (Frank Rosenblatt) مفهوم پرسپترون را معرفی کرد، یک الگوریتم یادگیری که میتوانست مسائل دستهبندی خطی را حل کند. برنارد ویدرو (Bernard Widrow) و مارسیان هاف (Marcian Hoff) نیز آدالاین (ADALINE) را توسعه دادند که از قانون یادگیری دلتا برای تنظیم وزنهای شبکه استفاده میکرد. این تلاشهای اولیه، شور و هیجان زیادی را در زمینه هوش مصنوعی برانگیخت، اما محدودیتهای این مدلهای ساده در حل مسائل پیچیدهتر، منجر به دورهای از رکود موسوم به “زمستان هوش مصنوعی” شد.

- دهه 1980: بازگشت شبکههای عصبی با پسانتشار: توسعه الگوریتم پسانتشار (Backpropagation) توسط دیوید روملهارت (David Rumelhart)، جفری هینتون (Geoffrey Hinton) و رونالد ویلیامز (Ronald Williams) جان تازهای به شبکههای عصبی بخشید. این الگوریتم امکان آموزش موثر شبکههای عصبی چندلایه را فراهم میکرد و راه را برای یادگیری الگوهای پیچیدهتر هموار ساخت.

- دهه 1990: ظهور CNN و RNN: شبکههای عصبی کانولوشنی (Convolutional Neural Networks – CNNs) با معماری خاص خود برای پردازش دادههای شبکهای مانند تصاویر، توسط یان لکان (Yann LeCun) و همکارانش توسعه یافتند و در تشخیص دستنوشتهها به موفقیتهای چشمگیری دست یافتند. همچنین، شبکههای عصبی بازگشتی (Recurrent Neural Networks – RNNs) با قابلیت پردازش دادههای متوالی مانند متن و صدا، مورد توجه قرار گرفتند.

- 2012: پیروزی AlexNet در ImageNet: نقطه عطفی در تاریخ یادگیری عمیق، پیروزی چشمگیر شبکه AlexNet در مسابقه ImageNet بود. این شبکه عمیق با استفاده از معماری CNN و بهرهگیری از قدرت پردازش موازی واحدهای پردازش گرافیکی (GPUs)، توانست دقت بیسابقهای در تشخیص تصاویر از خود نشان دهد و موج جدیدی از تحقیقات و کاربردهای یادگیری عمیق را به راه اندازد.

- 2023: ظهور ترانسفورمرهای بزرگ (GPT-4): معماری ترانسفورمر (Transformer)، که برای اولین بار در سال 2017 معرفی شد، انقلابی در پردازش زبانهای طبیعی (NLP) ایجاد کرد. مدلهای زبانی بزرگ مبتنی بر ترانسفورمر مانند GPT-4، قادر به تولید متن با کیفیت بالا، ترجمه زبانها، پاسخ به سوالات و انجام طیف وسیعی از وظایف زبانی با دقت و انسجام بینظیر هستند. این پیشرفتها، تأثیر عمیقی بر نحوه تعامل انسان با ماشین و اتوماسیون بسیاری از فرآیندهای مبتنی بر زبان داشته است.

انواع مدل های یادگیری عمیق

معماریهای متنوعی برای مدلهای یادگیری عمیق وجود دارد که هر کدام برای نوع خاصی از داده و وظیفه طراحی شدهاند. درک این تنوع، به انتخاب مناسبترین مدل برای چالشهای کسبوکاری کمک میکند.

1. شبکههای عصبی کانولوشنی (CNN)

- کاربرد اصلی: پردازش تصویر و ویدئو، تشخیص الگو در دادههای شبکهای (مانند تحلیل دادههای حسگر).

- نحوه عملکرد: CNNها از لایههای کانولوشن برای استخراج ویژگیهای محلی از دادههای ورودی استفاده میکنند. این لایهها با اعمال فیلترهای کوچک بر روی بخشهای مختلف ورودی، الگوهایی مانند لبهها، گوشهها و بافتها را شناسایی میکنند. لایههای تجمیع (Pooling) نیز برای کاهش ابعاد ویژگیها و افزایش مقاومت مدل در برابر تغییرات جزئی در ورودی به کار میروند. در نهایت، لایههای کاملاً متصل (Fully Connected) برای انجام وظیفه نهایی دستهبندی یا رگرسیون استفاده میشوند.

- نمونه موفق: سیستمهای تشخیص چهره در تلفنهای هوشمند و سامانههای امنیتی، خودروهای خودران برای تشخیص اشیاء و علائم راهنمایی و رانندگی، سیستمهای تشخیص پزشکی برای تحلیل تصاویر رادیولوژی و MRI. برای مثال، شرکت گوگل از CNNها در سیستم تشخیص چهره Google Photos استفاده میکند که با دقت بالایی افراد را در تصاویر مختلف شناسایی و گروهبندی میکند.

2. شبکههای عصبی بازگشتی (RNN)

- کاربرد اصلی: پردازش دادههای متوالی مانند متن، صدا، سریهای زمانی و دنبالههای DNA.

- نحوه عملکرد: RNNها دارای حلقههای بازگشتی هستند که به آنها اجازه میدهند اطلاعات مربوط به ورودیهای قبلی را در حافظه خود نگه دارند و از آن برای پردازش ورودیهای بعدی استفاده کنند. این ویژگی، RNNها را برای مدلسازی وابستگیهای زمانی در دادههای متوالی مناسب میسازد. انواع مختلفی از RNNها مانند شبکههای حافظه بلند-کوتاه مدت (Long Short-Term Memory – LSTM) و واحدهای بازگشتی دروازهدار (Gated Recurrent Units – GRUs) برای حل مشکل محو شدن گرادیان در RNNهای ساده و یادگیری وابستگیهای طولانیتر در دادهها توسعه یافتهاند.

- نمونه موفق: سیستمهای ترجمه ماشینی مانند Google Translate که متن را از یک زبان به زبان دیگر ترجمه میکنند، سیستمهای تشخیص گفتار مانند Siri و Alexa که دستورات صوتی را تشخیص میدهند، مدلهای تولید متن که میتوانند داستان، شعر یا کد تولید کنند. به عنوان مثال، سیستم ترجمه ماشینی گوگل از معماریهای مبتنی بر LSTM و ترانسفورمر برای ارائه ترجمههای روان و دقیق استفاده میکند.

3. ترانسفورمرها

- تحولآفرین در پردازش زبانهای طبیعی: معماری ترانسفورمر با معرفی مکانیسم توجه (Attention Mechanism) رویکرد جدیدی در پردازش دادههای متوالی ارائه کرد. بر خلاف RNNها که به صورت متوالی ورودیها را پردازش میکنند، ترانسفورمرها میتوانند به طور همزمان به تمام بخشهای ورودی توجه کنند و روابط بین آنها را مدلسازی کنند. این ویژگی، ترانسفورمرها را به ویژه در پردازش زبانهای طبیعی بسیار قدرتمند ساخته است.

- نحوه عملکرد: ترانسفورمرها از مکانیسمهای خود-توجه (Self-Attention) برای وزندهی به اهمیت کلمات مختلف در یک جمله نسبت به یکدیگر استفاده میکنند. این مکانیسم به مدل اجازه میدهد تا وابستگیهای دوربرد بین کلمات را به طور موثرتری یاد بگیرد. معماری ترانسفورمر معمولاً شامل یک بخش رمزگذار (Encoder) برای پردازش ورودی و یک بخش رمزگشا (Decoder) برای تولید خروجی است.

- نمونه: ChatGPT، یک مدل زبانی بزرگ مبتنی بر معماری ترانسفورمر که قادر به تولید متن، پاسخ به سوالات و انجام مکالمات تعاملی است. مدلهای دیگری مانند BERT برای درک معنای متن و T5 برای انجام وظایف مختلف NLP به صورت یکپارچه نیز بر پایه معماری ترانسفورمر ساخته شدهاند.

بهترین روشهای پیادهسازی یادگیری در پروژه ها

پیادهسازی موفق پروژههای یادگیری عمیق نیازمند یک رویکرد ساختاریافته و گام به گام است. چارچوب 7 مرحلهای زیر میتواند به سازمانها در این مسیر کمک کند:

چارچوب 7 مرحلهای

- تعریف مسئله کسبوکار: اولین و مهمترین گام، شناسایی دقیق مسئله کسبوکاری است که میخواهید با استفاده از یادگیری عمیق حل کنید. این مسئله باید واضح، قابل اندازهگیری و همسو با اهداف استراتژیک سازمان باشد. برای مثال، کاهش نرخ ریزش مشتریان، بهبود کیفیت محصولات، بهینهسازی زنجیره تامین یا شخصیسازی تجربه مشتری میتواند از جمله مسائل مورد نظر باشد.

- جمعآوری و برچسبزنی دادهها: یادگیری عمیق به حجم زیادی از دادههای باکیفیت نیاز دارد. در این مرحله، دادههای مرتبط با مسئله تعریفشده جمعآوری شده و در صورت نیاز، برچسبگذاری میشوند. برچسبگذاری دادهها، به ویژه برای وظایف یادگیری نظارتشده، از اهمیت بالایی برخوردار است زیرا مدل با استفاده از این برچسبها الگوها را یاد میگیرد. کیفیت و کمیت دادهها، تاثیر مستقیمی بر عملکرد نهایی مدل خواهد داشت.

- انتخاب معماری مدل: با توجه به نوع مسئله و دادههای موجود، معماری مناسب مدل یادگیری عمیق انتخاب میشود. همانطور که در بخش قبل توضیح داده شد، CNNها برای پردازش تصویر، RNNها برای دادههای متوالی و ترانسفورمرها برای پردازش زبانهای طبیعی مناسب هستند. انتخاب معماری مناسب، کارایی و دقت مدل را به طور قابل توجهی تحت تاثیر قرار میدهد.

- آموزش و اعتبارسنجی: در این مرحله، مدل با استفاده از دادههای آموزشی، الگوها را یاد میگیرد. فرآیند آموزش شامل تنظیم وزنهای شبکه عصبی به گونهای است که خطا در پیشبینیها به حداقل برسد. برای ارزیابی عملکرد مدل در طول آموزش و جلوگیری از بیشبرازش (Overfitting)، از دادههای اعتبارسنجی (Validation Data) استفاده میشود.

- استقرار (Deployment): پس از آموزش و ارزیابی موفقیتآمیز مدل، نوبت به استقرار آن در محیط عملیاتی میرسد. این میتواند شامل ادغام مدل با سیستمهای موجود، ایجاد یک API برای دسترسی به قابلیتهای مدل یا استقرار آن بر روی دستگاههای لبهای باشد. انتخاب روش استقرار مناسب، به نیازهای کسبوکار و زیرساختهای موجود بستگی دارد.

- پایش عملکرد: پس از استقرار، عملکرد مدل به طور مداوم پایش میشود تا اطمینان حاصل شود که همچنان با دقت مورد انتظار عمل میکند. عواملی مانند تغییر در توزیع دادهها (Data Drift) میتوانند باعث کاهش عملکرد مدل در طول زمان شوند. پایش منظم به شناسایی این مشکلات و انجام اقدامات اصلاحی کمک میکند.

- بهبود مستمر: یادگیری عمیق یک فرآیند تکراری است. بر اساس نتایج پایش عملکرد و بازخوردهای دریافتی، مدل میتواند به طور مداوم بهبود یابد. این ممکن است شامل جمعآوری دادههای جدید، تنظیم ابرپارامترهای مدل، تغییر معماری یا آموزش مجدد مدل باشد.

مثال: سیستم پیشبینی تقاضا والمارت با دقت 95%

شرکت والمارت (Walmart)، یکی از بزرگترین خردهفروشان جهان، از سیستمهای پیشبینی تقاضا مبتنی بر یادگیری عمیق برای مدیریت موجودی کالا و بهینهسازی زنجیره تامین خود استفاده میکند. این سیستمها با تحلیل حجم وسیعی از دادههای فروش تاریخی، فصلی بودن، رویدادهای خاص و سایر عوامل موثر، قادر به پیشبینی دقیق تقاضا برای محصولات مختلف هستند. دقت 95% این سیستمها منجر به کاهش هزینههای انبارداری، جلوگیری از کمبود کالا و بهبود رضایت مشتریان شده است. این مثال نشان میدهد که پیادهسازی صحیح یادگیری عمیق میتواند تاثیر قابل توجهی بر کارایی و سودآوری کسبوکار داشته باشد.

ترندهای یادگیری عمیق

حوزه یادگیری عمیق به سرعت در حال تکامل است و ظهور ترندهای جدید، امکانات و چالشهای جدیدی را پیش روی سازمانها قرار میدهد. آگاهی از این ترندها میتواند به سازمانها در اتخاذ تصمیمات استراتژیک آگاهانهتر کمک کند.

1. یادگیری خودنظارتی (Self-Supervised Learning)

- کاهش نیاز به دادههای برچسبدار: یکی از چالشهای اصلی در یادگیری عمیق، نیاز به حجم زیادی از دادههای برچسبدار است که جمعآوری و برچسبزنی آنها میتواند زمانبر و پرهزینه باشد. یادگیری خودنظارتی رویکردی است که در آن مدلها بدون نیاز به برچسبهای صریح، از ساختار خود دادهها برای یادگیری ویژگیهای مفید استفاده میکنند. برای مثال، یک مدل میتواند با پنهان کردن بخشهایی از یک تصویر و آموزش برای بازسازی آن بخشهای پنهان، ویژگیهای بصری را یاد بگیرد. این رویکرد، به ویژه در زمینههایی که جمعآوری دادههای برچسبدار دشوار است، بسیار امیدوارکننده است.

2. مدلهای سبکوزن (TinyML)

- اجرا روی دستگاههای لبهای: TinyML به توسعه مدلهای یادگیری عمیق با اندازه کوچک و مصرف انرژی پایین اشاره دارد که میتوانند بر روی دستگاههای لبهای (Edge Devices) مانند میکروکنترلرها، حسگرها و تلفنهای همراه اجرا شوند. این امر امکان پردازش دادهها در محل تولید آنها را فراهم میکند، که منجر به کاهش تاخیر، افزایش حریم خصوصی و کاهش وابستگی به اتصال اینترنت میشود. کاربردهای TinyML شامل تشخیص ناهنجاری در تجهیزات صنعتی، تشخیص صدا در دستگاههای هوشمند و نظارت بر سلامت در پوشیدنیها است.

3. یادگیری تقویتی عمیق (Deep Reinforcement Learning)

- بهینهسازی سیستمهای پیچیده: یادگیری تقویتی عمیق، ترکیبی از یادگیری تقویتی و یادگیری عمیق است که به عاملهای نرمافزاری اجازه میدهد تا از طریق آزمون و خطا در یک محیط پیچیده، بهترین استراتژیها را برای رسیدن به یک هدف خاص یاد بگیرند. این رویکرد در زمینههایی مانند رباتیک، بازیهای رایانهای، سیستمهای توصیه و مدیریت منابع بسیار موثر بوده است. برای مثال، از یادگیری تقویتی عمیق برای آموزش رباتها برای انجام وظایف پیچیده در محیطهای ناشناخته یا بهینهسازی استراتژیهای معاملاتی در بازارهای مالی استفاده میشود.

ابزارهای کلیدی در حوزه یادگیری عمیق

برای توسعه و پیادهسازی پروژههای یادگیری عمیق، مجموعهای از ابزارها و فناوریها در اختیار توسعهدهندگان و سازمانها قرار دارد.

| دستهبندی | ابزارها | کاربرد |

| چارچوبها | TensorFlow | توسعه مدلهای یادگیری عمیق سفارشی |

| PyTorch | تحقیق و توسعه، انعطافپذیری بالا | |

| Keras | رابط کاربری سطح بالا برای TensorFlow و سایر بکاندها | |

| پلتفرمها | AWS SageMaker | استقرار، مدیریت و مقیاسبندی مدلها |

| Google AI Platform | ابزارهای جامع برای چرخه عمر مدلهای یادگیری عمیق | |

| Microsoft Azure Machine Learning | پلتفرم مبتنی بر ابر برای ساخت، آموزش و استقرار مدلها | |

| کتابخانهها | Hugging Face | مدلهای از پیشآموخته، ابزارهای NLP |

| scikit-learn | الگوریتمهای یادگیری ماشین سنتی و ابزارهای پیشپردازش داده | |

| OpenCV | پردازش تصویر و ویدئو |

انتخاب ابزار مناسب به نیازهای خاص پروژه، تخصص تیم و زیرساختهای موجود بستگی دارد.

مهارت های مورد نیاز برای پیاده سازی یادگیری عمیق

موفقیت در پیادهسازی پروژههای یادگیری عمیق نیازمند ترکیبی از مهارتهای فنی و غیرفنی است.

مهارت های سخت

برنامهنویسی پیشرفته پایتون: پایتون زبان برنامهنویسی غالب در حوزه یادگیری عمیق است. تسلط بر کتابخانههای کلیدی مانند NumPy، Pandas، scikit-learn و چارچوبهای یادگیری عمیق مانند TensorFlow و PyTorch ضروری است.

محمدمهدی صفایی میگه:

مظاهری میگه:

Mz میگه: